今回はAll In One SEO PackのRobots.txt機能の解説と、robots.txtでできるロボット巡回の許可(拒否)設定例をいくつかまとめてご紹介します。

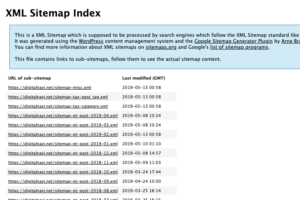

robots.txtは、検索エンジンのクローラー(ロボット)に対してブログの巡回を許可(拒否)するかどうかの設定を書いたファイルのことです。

あまり使う機会がないかもしれませんが、万一編集しないといけなくなった場合は、All In One SEO Packプラグインを使って、この記事の内容を参考に設定などしてもらえると有り難いです。

目次

All In One SEO PackのRobots.txtの特徴

まずはAll In One SEO PackのRobots.txtでできることや、特徴について紹介します。

- robots.txtというテキストファイルを自分で用意しなくてよい

- サーバーへのrobots.txtをアップロードしたりダウンロードしなくてよい

- 管理画面で設定に必要な項目を埋めていくだけなので、記述ミスが起こりにくい

WordPressはインストールすると「仮想、Robots.txt」と呼ばれるファイルが勝手に生成されます。仮想のため、物理的にサーバーにファイルがあるわけではないので、いざ編集しようとするとちょっと手間なんですね。そこで、管理画面からRobots.txtできるAll In One SEO Packのようなプラグインは便利なわけですね。

また、あとでいくつか紹介しますが、自分でrobots.txtを作成するとなると「User-agent: * Disallow: /wp-admin/…」のような呪文を書かないといけないのがネックです。。。

でも、All In One SEO Packなら「どのロボットがどのフォルダやファイルを巡回することを許可(または拒否)するか?」を穴埋めしていくだけでOKなんで、初心者の方でも設定しやすい作りになっています。

Robots.txtの使いどころ

プラグインの使い方の前に、「そもそもRobots.txtって何をどうするのものなの?」という人もいると思うので、簡単に解説しておきます。

冒頭でも触れたとおり、Robots.txtは「クローラー(ロボット)の巡回を許可したり拒否する設定を書くためのファイル」です。例えば

・・・

このような設定が書かれているのがRobots.txtなんです。

All In One SEO PackのRobots.txt機能を使うには?

All In One SEO Packをインストールする必要がありますが、プラグインのインストールから基本的な設定については、関連記事にまとめていますので、参考にしてもらえればと思います。

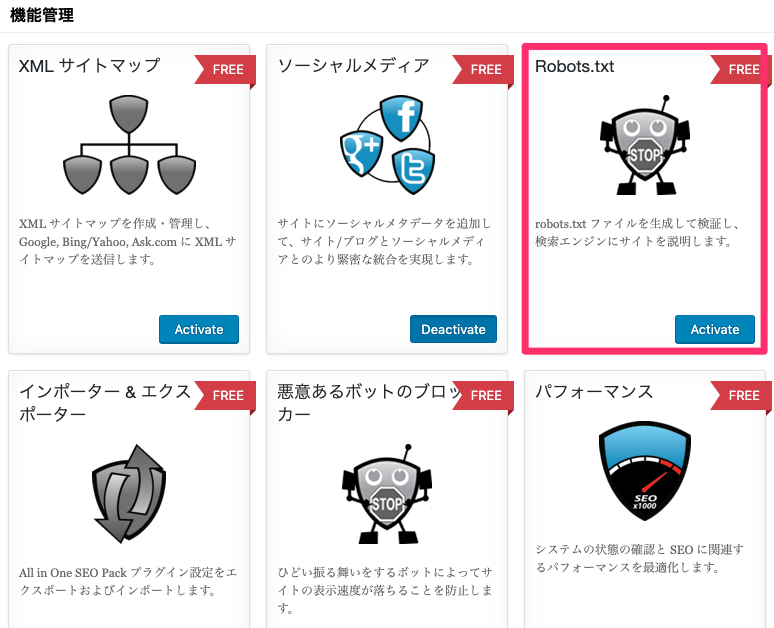

All In One SEO Packを有効化したら「機能管理」へ進んで

Robots.txtの「Active」ボタンをクリックします。

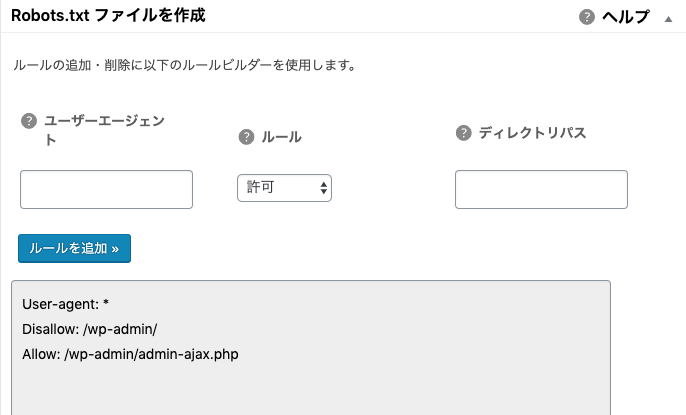

Robots.txtファイルを作成

All in one SEOのRobots.txtページで、ロボット毎のルールを追加していきます。

実際には「ルールビルダー」というのを使用して穴埋めしていくだけなんですが、入力・選択する項目は以下の通りです。

ルール

ディレクトリパス

で、これらの設定項目と入力例を表にまとめました。

| 項目 | 入力・選択例 |

|---|---|

| ユーザーエージェント |

* Googlebot Googlebot-Mobile Google-Image など |

| ルール | 許可する(Allow) 許可しない(Disallow) |

| ディレクトリパス | / /wp-admin/ /wp-admin/admin-ajax.php /wp-content/uploads/ など |

補足しておくと、

①ユーザーエージェント

これは「Googlebot」「Googlebot-Mobile」「Google-Imag」と呼ばれるクローラー(ロボット)の名称です。「*(アスタリスク)」を指定すると、全てのクローラーに対するコントロールができるようになります。

②ルール

これは「許可する(Allow)」「許可しない(Disallow)」の2つから選びます。

③ディレクトリパス

ファイルやフォルダが存在する場所(パス)のことです。

ブログURLである「https://digitalnavi.net」の部分が省略されたもの、

と考えておけば良いでしょう。

・・・

このユーザーエージェント、ルール、ディレクトリパスを組み合わせてRobots.txtファイルを作成していくんですが、「何をどんな感じで入力するのか分からないよ…」って人も多いと思うので、以下にいくつか設定サンプルを用意しました。

特定のディレクトリの巡回は拒否するが、その中のあるファイルだけは巡回を許可する

まず、WordPressをインストールしたら仮想Robots.txtに以下のような記述が追加されていますので、何が書いてあるのかを見ていくことにしましょう。

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

User-agentが「*」なのですべてのロボットを指しています。ルールは2つ指定されていて、1つ目が「Disallow」なんで許可しない。で、そのディレクトリパスが「/wp-admin/」です。つまりWordPress管理画面内のファイルを巡回ブロックしているわけです。

で、次のルールが「Allow」なので許可です。そのディレクトリパスが「/wp-admin/admin-ajax.php」なので、1つ目のルールと組み合わせると「

/wp-admin/のフォルダ内は巡回したらダメだけど、admin-ajax.phpというファイルだけはOKよ。」ということになります。

ややこしいですが、このようにルールは重ねがけすることができます。

membersという会員専用フォルダを巡回拒否にする

1例目となんとなく同じパターンですが、実際にどうやってAll In One SEO PackのRobots.txtページでルールを追加するかを見ておきましょう。

Disallow: /members/

巡回拒否するファイルの場所がhttps://ドメイン名/members/の場合、ディレクトリパスは/members/です。

なので、Robots.txtページでルールを追加するとこうなります。

「ルールを追加」ボタンをクリックすると、↓こんな感じで追加されました。

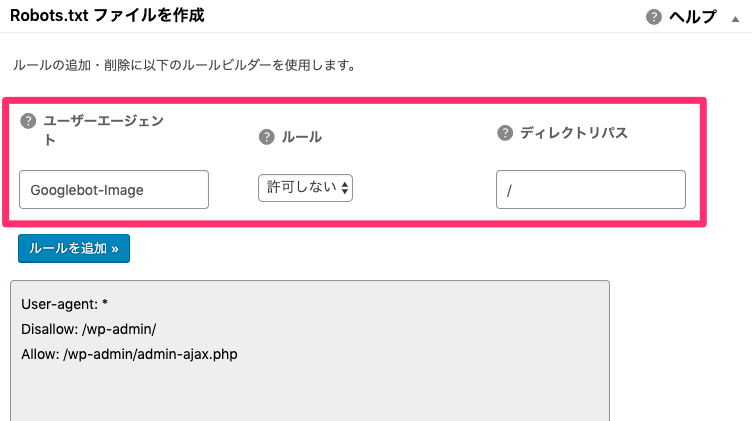

Google画像検索ロボットの巡回を拒否する

次のルールは画像ファイルの巡回拒否についてです。

Disallow: /

Googlebot-ImageはGoogleの画像検索ロボットです。ルールはDisallowなんで許可しない。ディレクトリパスが/なので、対象はブログ全体です。つまり、ブログの中で使われているJPGやPNG、GIFといった画像ファイルを巡回させないようにする指定です。

これを、All In One SEO PackのRobots.txtページで設定する場合はこうなります。

wp-content内のフォルダを巡回拒否したり許可したりする

WordPressのwp-content/のフォルダには、themes/とかplugins/とかuploads/とか色々フォルダが入っています。やる意味があるかないかは別として、これらのフォルダに対して個別にロボットの巡回設定をする方法を参考までにご紹介します。

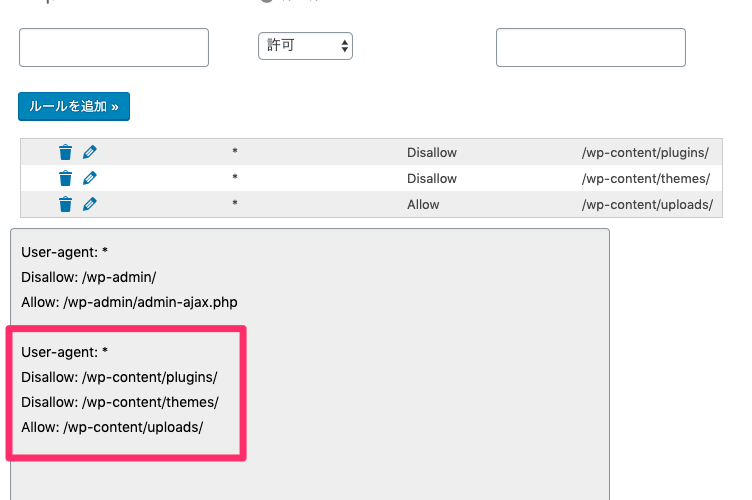

最終的に目指すのは↓こんな設定です。

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Allow: /wp-content/uploads/

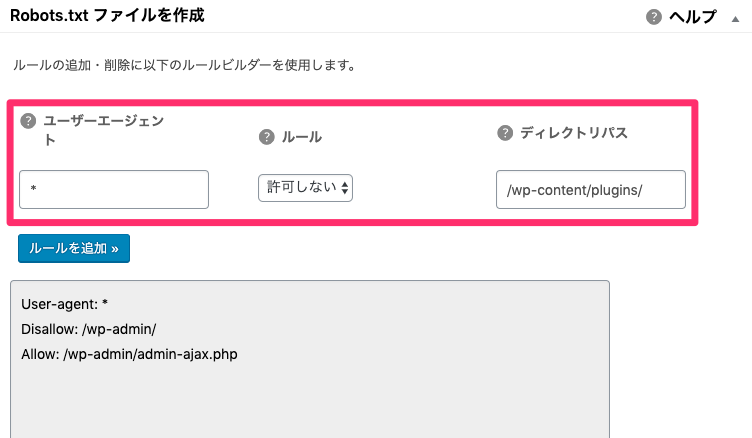

まずは1個目「plugins」フォルダに対するルールを決めて、

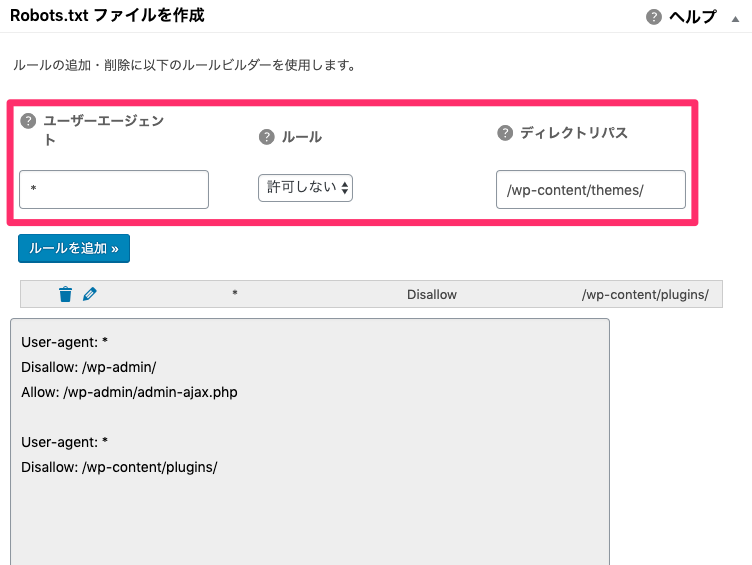

2個目の「themes」フォルダ、

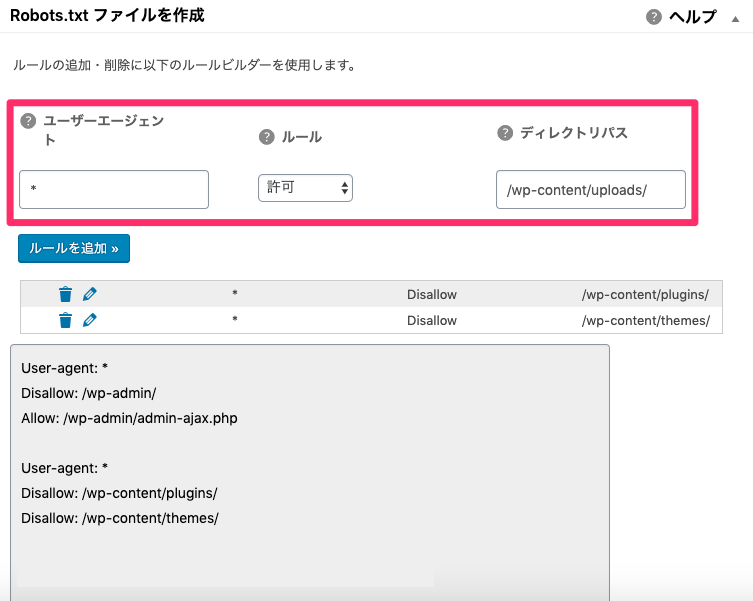

3個目の「uploads」フォルダと、順番にルールを追加していくと、

うまく追加できたみたいです★

実際のところ、この辺りはあまり神経質にやり過ぎる必要はないと思うので、あくまでAll In One SEO Packプラグインの使い方ということで参考にしてもらえると幸いです。